- 518.05 KB

- 2022-04-22 13:43:20 发布

- 1、本文档共5页,可阅读全部内容。

- 2、本文档内容版权归属内容提供方,所产生的收益全部归内容提供方所有。如果您对本文有版权争议,可选择认领,认领后既往收益都归您。

- 3、本文档由用户上传,本站不保证质量和数量令人满意,可能有诸多瑕疵,付费之前,请仔细先通过免费阅读内容等途径辨别内容交易风险。如存在严重挂羊头卖狗肉之情形,可联系本站下载客服投诉处理。

- 文档侵权举报电话:19940600175。

'中国科技论文在线http://www.paper.edu.cn基于平方根无迹卡尔曼滤波的机器人无标#定视觉伺服**樊阳立,孙炜5(湖南大学电气与信息工程学院,长沙410082)摘要:针对基于图像雅可比矩阵的机器人无标定视觉伺服问题,提出了一种基于平方根无迹卡尔曼滤波的图像雅可比矩阵在线估计方法。该方法以总图像雅可比矩阵的元素作为系统状态,将问题转变为对系统状态的估计,再引入能处理非线性问题的平方根无迹卡尔曼滤波对系统状态进行估计,从而实现对总图像雅10可比矩阵的在线估计,避免了复杂的系统标定过程。以二自由度机器人跟踪运动目标为视觉伺服任务,将新提出的方法与基于卡尔曼滤波和无迹卡尔曼滤波的估计方法进行实验比较。仿真实验结果表明,所提出的图像雅可比矩阵在线估计方法具有更高的估计精度和更强的鲁棒性。关键词:机器人;无标定视觉伺服;图像雅可比矩阵;平方根无迹卡尔曼滤波中图分类号:TP2415Uncalibratedvisualservoingforrobotsbasedonsquare-rootunscentedKalmanfilterFANYangli,SUNWei(CollegeofElectricalandInformationEngineering,HunanUniversity,Changsha410082,China)20Abstract:ConsideringtheproblemofrobotuncalibratedvisualservoingbasedonanimageJacobianmatrix,anovelon-lineestimationofimageJacobianmatrixmethodbasedonthesquare-rootunscentedKalmanfilterisproposed.Inthismethod,astatevectorisformedfromtheelementsofatotalimageJacobianmatrix,andtheproblemisconvertedintooneofsystemstateestimations,thenasquare-rootunscentedKalmanfiltersuitablefornonlinearsystemsisutilizedforestimationofsystemstate,thus25theon-lineestimationoftotalimageJacobianmatrixisrealizedandthecomplexsystemcalibrationprocesscanbeavoided.TheproposedmethodandtheonesbasedonKalmanfilterandunscentedKalmanfilteraretestedtotrackamovingtargetonatwodegree-of-freedomrobotvisualservoingsystem.Simulationresultsindicatethat,theproposedmethodoutperformsothertwoinestimationaccuracyandrobustness.30Keywords:robot;uncalibratedvisualservoing;imageJacobianmatrix;square-rootunscentedKalmanfilter0引言35机器人视觉伺服是机器人领域的一个重要研究方向。视觉伺服利用视觉传感器获得的图像作为反馈信息,构造机器人的闭环位置控制。根据视觉反馈信号的不同形式可以将机器人视觉伺服系统分为基于位置的视觉伺服(position-basedvisualservoing,PBVS)、基于图像的视觉伺服(image-basedvisualservoing,IBVS)和混合视觉伺服(又称2.5D视觉伺服)[1]三种类型。其中IBVS直接利用图像特征进行视觉信息反馈控制,结构简单、对系统标定[2]40误差具有一定鲁棒性,因而在实际系统中得到广泛应用。在IBVS系统中,使用图像雅可比矩阵来描述图像特征的变化与机器人位姿的变化之间的映射关系,这个关系是高度非线性[3]的,需要在机器人运动过程中实时更新。因而,图像雅可比矩阵的求取是IBVS系统的关基金项目:高等学校博士学科点专项科研基金(20130161110009)作者简介:樊阳立(1990年-)男,湖南衡阳人,硕士研究生,主要研究方向:机器人视觉伺服通信联系人:孙炜(1975年-),男,教授、博导,主要研究方向:机器人与智能控制、汽车电子、智能信息处理.E-mail:david-sun@126.com-1-

中国科技论文在线http://www.paper.edu.cn键问题。传统IBVS求取图像雅可比矩阵需要精确的摄像机标定模型和机器人运动学模型,但由于实际中标定算法较为复杂、标定结果存在误差、对环境变化敏感以及某些特殊场合难[4]45以进行标定等原因,大大限制了这种基于标定的视觉伺服方法在实际中的应用。因此,在无标定环境下在线估计图像雅可比矩阵的视觉伺服方法成为一个研究热点方向。[5-7]近些年来,研究人员对无标定视觉伺服方法进行了广泛研究,并取得了大量研究成果。[8]文献通过建立状态空间模型,将待估计的图像雅可比矩阵元素作为该系统的状态,再采用卡尔曼滤波(KalmanFilter,KF)算法对系统的状态进行观测,从而实现图像雅可比矩阵的50在线估计。该方法计算量小,实时性好,对系统噪声具有一定的鲁棒性。针对KF算法需要[9]假设系统噪声为方差恒定的高斯噪声,文献利用模糊策略自适应调节用于系统状态估计的过程噪声和图像观测噪声协方差矩阵,提出了基于模糊自适应卡尔曼滤波的图像雅可比矩阵在线估计方法。然而KF算法是针对时变线性系统,而图像雅可比矩阵描述的映射关系是高[10]度非线性的,因此KF算法对图像雅可比矩阵的估计精度有限。文献引入了适用于非线性55-非高斯系统的粒子滤波(ParticleFilter,PF),提出了基于粒子滤波的图像雅可比矩阵在线[11]估计方法。但PF算法计算量大,实时性差,粒子经过迭代后会产生退化问题。文献引入了适用于非线性-高斯系统的无迹卡尔曼滤波(UnscentedKalmanFilter,UKF),提出了基于无迹卡尔曼滤波的图像雅可比矩阵在线估计方法。但由于UKF算法数值计算中往往存在舍入误差等问题,有可能引起误差协方差矩阵非正定而导致UKF滤波器无法正常工作。60针对UKF算法存在的问题,本文引入对UKF算法进行改进的平方根无迹卡尔曼滤波[12](Square-RootUnscentedKalmanFilter,SR-UKF)算法对图像雅可比矩阵进行在线估计,从而提出了一种新的图像雅可比矩阵在线估计方法。在仿真实验中,对基于KF、UKF和SR-UKF的三种估计方法进行实验比较,验证了基于SR-UKF算法在线估计总图像雅可比矩阵方法的有效性。651平方根无迹卡尔曼滤波算法SR-UKF算法以无迹变换技术(UnscentedTransform,UT)为基础,直接以误差协方差矩阵的平方根矩阵进行递推计算,再采用KF的框架进行状态预测与测量更新,实现对非线性系统的估计。SR-UKF算法在迭代计算中不需要每次都计算误差协方差矩阵的平方根,提高了计算效率;另外,利用平方根得到的误差协方差矩阵一定是非负定的,避免了标准UKF70算法由于误差协方差矩阵非正定而引起的滤波发散,提高了算法的稳定性。在SR-UKF中,需要使用QR分解和Cholesky一阶更新,下面分别给出两者的定义。PAAT,其中mn()AT进行QR分解,即TQR分解:若矩阵ARnm,则可对AQR,其中nnRRnm为上三角矩阵。由此可得TTTRT即QR为正交矩阵,PRQQRRR,为P的Cholesky因子。T75Cholesky一阶更新:如果S为下三角矩阵,P为对称正半定矩阵,且PSS,则称ST是P的Cholesky因子,记为SPchol()。同时,称矩阵Pvuu的Cholesky因子为Cholesky一阶更新,可表示为cholupdate(S,u,v)。SR-UKF算法流程如下:1)系统初始化-2-

中国科技论文在线http://www.paper.edu.cn80初始化均值Xˆ和误差协方差平方根矩阵S。00XˆEX[]00(1)Schol{[(EXXˆ)(XXˆ)]}T00000式中,chol函数表示Cholesky分解。2)选取Sigma点及加权系数SR-UKF采用确定性采样策略,称采样的粒子点为Sigma点。不同于UKF算法,SR-UKF85算法直接用误差协方差矩阵的平方根S计算得到2n+1个Sigma点,XˆXˆSXˆS(2)k1k1k1k1k1k1()mW0n()c2W(1)(3)0n()mc()1WW,i12,,,n2ii2(n)2式中,n;n是状态变量X的维数;()nn是一个尺度调节因子;决k定了所选取的Sigma点在其均值X附近的分布情况,通常将设置为一个很小的正值490(101);是次级尺度调节因子,通常设置为0;是用来体现X分布的先验知识(对于高斯分布,的最佳取值为2);Wi表示第i个Sigma点的权值,且满足Wi1;()m()cW是用来计算均值的权值;W是用来计算协方差的权值。ii3)时间更新采用UT变换将每个Sigma采样点进行非线性变换,并计算变换后采样点的均值与误差()c95协方差平方根矩阵。由于W有可能为负值,为保证误差协方差平方根矩阵S的半正定性,0有必要进行Cholesky一阶更新。()(4)k|k11k2nXWˆ()m(5)kii,k|k1i0SqrW()c(Xˆ)Q(6)k112:n,k|k1kw,k100ScholupdateS,X,Wˆ()c(7)kk0,k|k1k0Zh()(8)k|k11k|k2n()mˆzkWiZi,k|k1(9)i0式中,Q为过程噪声协方差矩阵,qr函数和cholupdate函数分别表示QR分解和Choleskyw,k一阶更新。1054)测量更新使用卡尔曼增益对系统均值和误差协方差矩阵平方根进行更新,得到后验的状态估计。注意到S是半正定的上三角矩阵,采用最小二乘法计算式(13)从而避免求逆运算。-3-

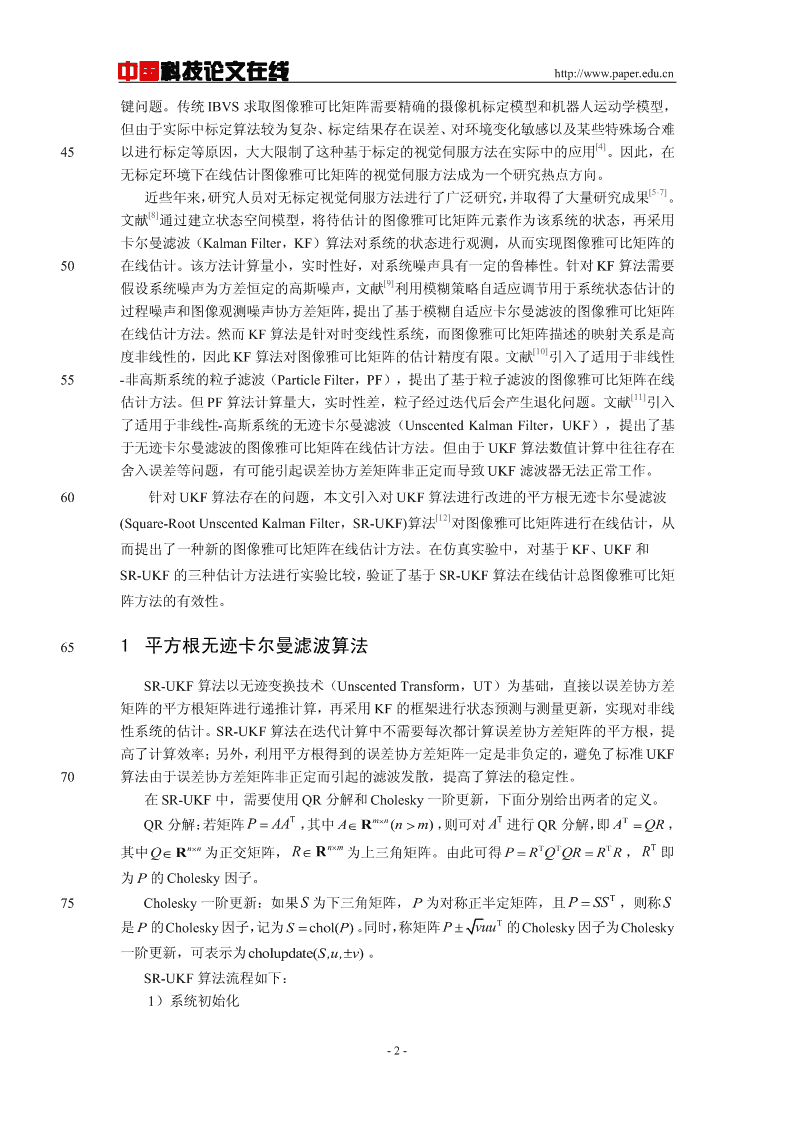

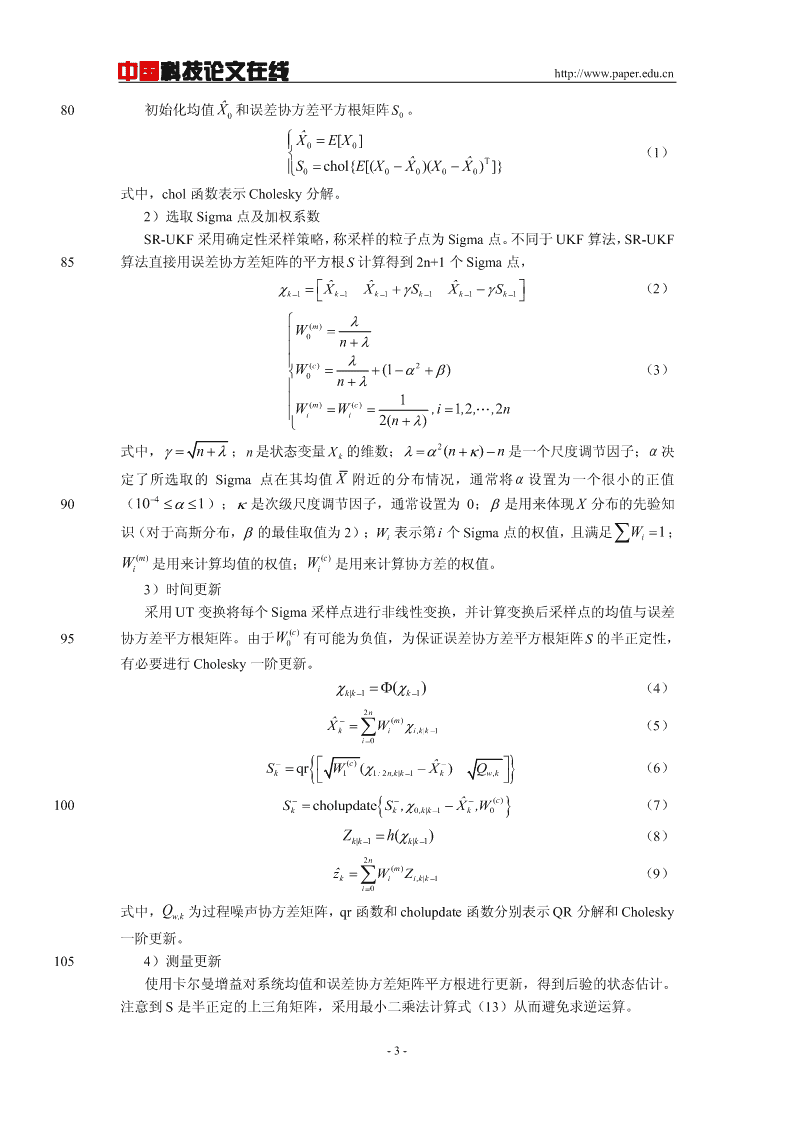

中国科技论文在线http://www.paper.edu.cnSqrW()c(Zˆz)Q(10)z,k112:n,k|k1kv,k()cSz,kcholupdateS,Zz,k0,k|k1ˆz,Wk0(11)2n110PW()c(Xˆ)(Zˆz)T(12)xz,kii,k|k11ki,k|kki0TK()P/S/S(13)kxz,kz,kz,kXˆXˆKz()ˆz(14)kkkkkUKS(15)kz,kSkkcholupdateS,U,1(16)115式中,Q为观测噪声协方差矩阵。v,k2基于图像的无标定视觉伺服基于图像的无标定视觉伺服系统(如图1所示),不需要精确的摄像机标定模型和机器人运动学模型,直接通过图像特征误差设计控制律,控制机器人运动最终使图像特征误差趋近于零,从而完成机器人视觉伺服任务。图像雅可比矩阵的在线估计是基于图像的无标定视120觉伺服系统的关键问题,本文引入能处理非线性问题的SR-UKF算法实现对总图像雅可比矩阵的在线估计。targetyfr视觉控制器机器人-Jy在线估计图像雅可比矩阵y图像特征提取摄像机图1基于图像的无标定视觉伺服2.1总图像雅可比矩阵125在基于图像的视觉伺服系统中,用图像雅可比矩阵来描述机器人关节空间与图像特征空间的微分映射关系,其定义如式(17)所示。yJ(17)yy111n式中,yJyymm1nmnTm其中,y[,,yy12,ym],yR为图像特征变化速度,Tn130[,,12,]n,R为机器人关节量变化速度,mnJR为图像雅可比矩阵。对于摄像机安装在机器人末端执行器(Eye-in-Hand)的视觉伺服系统,图像特征变化不仅和机器人末端执行器运动有关,还和目标的运动有关,那么式(17)定义的图像雅可比矩-4-

中国科技论文在线http://www.paper.edu.cn阵不适用于跟踪运动目标情况。设p表示目标的位置,Jy/p,则p135yJJp(18)p如果目标做连续运动,其位置p是随时间t而变化的,则图像特征y最终是机器人关节量和时间t的函数,即yy(),t。将y在(),t处进行泰勒级数展开,并忽略高阶项得yJJt(19)t式中,Jy/,Jy/t,yyy,,t为采样周期,Jtkk1kk1140表示由机器人关节运动而引起的图像特征变化,Jt表示由目标运动而引起的图像特征变t化。T定义JJJ为总图像雅可比矩阵,设t,则式(19)可以重写为tTyJJttJ(20)yyy111t1n式中,yJyyymmmt1nm(n1)1452.2基于SR-UKF的总图像雅可比矩阵在线估计首先,将总图像雅可比矩阵的定义式离散化,有yyJ(21)k1kkk为实现对总图像雅可比矩阵J各元素的在线估计,定义如下mn(1)1维观测向量,Tyyy12m150X(22)yyyyyiiiii式中,(i12,,,m)为总图像雅可比矩阵J的第i行向t12n量。定义总图像雅可比矩阵的观测向量X为k时刻的系统状态,机器人末端执行器运动以k及目标运动所引起的图像特征变化为系统输出,即zkyk1yk,得到如下状态空间模型,XXwk1kk155(23)zCXkkkkT0k式中,C,w和分别为过程噪声和图像观察噪声,假定为高kkk0Tkmmn(1)斯白噪声。在构造了系统的状态空间模型后,再使用SR-UKF算法对系统的状态进行递推估计,从而实现对总图像雅可比矩阵的在线估计。160总图像雅可比矩阵的递推估计需要一个较准确的初始值,通过在机器人初始位置任意给-5-

中国科技论文在线http://www.paper.edu.cn定n步线性无关的试探运动p,,p,并观察相应的图像特征变化f,,f,从而估计1n1n出图像雅可比矩阵的初始值,即Jˆ(f,,f)(p,,p)1(24),01n1n另外,令J0,从而得到总图像雅可比矩阵的初始估计值J。t,001652.3基于图像的无标定视觉伺服控制方法对于Eye-in-Hand机器人视觉伺服系统,设图像平面中目标当前图像特征为y(),t,期望图像特征为y,则实际图像特征与期望图像特征之间的偏差f(),t为f(,t)y(,t)y(25)通过控制机器人运动使机器人末端执行器跟踪目标,并使如下目标函数最小1T170F(,t)f(,t)f(,t)(26)2[13-14]使用高斯-牛顿法求解式(26)目标函数的最优问题,得到关节量的增量计算公式为T1Tfk(JJR)J(ft)(27)k,k,kk,kktT式中,Jf/,R()J/f,k为迭代次数,t为采样时间。,kkk,kk175式(27)中R的值难以计算,对于小偏差情况,当接近解时,R接近于零,这种情kkk况下常常可以忽略R不计。但对于大偏差情况,则不能忽略R不计,需要对R进行在线kkk[15]估计,即TT(JJ)f(),k,k11kkkR(28)kT()()kk11kk由式(25)可知,式(27)中f/tJ,因而,要实现以上无标定视觉伺服控制,kt,k180需要解决对J,k和Jt,k的确定,即需要对总图像雅可比矩阵Jk进行在线估计。本文采用SR-UKF算法在线估计总图像雅可比矩阵Jk,得到式(27)中J,k和f/tk的值,从而得到关节控制量,驱动机器人运动。算法1无标定视觉伺服算法初始化f:RnRm;Rn;JRmn(1);SRmn(1)mn(1);000mn(1)mn(1)mmQQRR;wv-6-

中国科技论文在线http://www.paper.edu.cnFork12,,,Nzyy,,fyykkk11kkkkkTJk1J,k1Jt,k1,kktC,XJkkk11k[X,S]srukf(X,S,C,z)kkk11kkkJX,JJJkk,kt,kkT1TTR()(JJ)fkkk,k,k1kkT1T(JJ+R)J(fJt)k1k,k,kk,kkt,k综上所述,本文提出的基于SR-UKF算法在线估计总图像雅可比矩阵的无标定视觉伺服185方法可总结为如下算法。其中srukf函数为上文的平方根无迹卡尔曼滤波算法。3仿真实验[16][17]在Matlab平台上使用PeterCorke的机器人工具箱和机器视觉工具箱进行仿真实验,以跟踪运动目标为视觉伺服任务,分别使用KF、UKF和SR-UKF三种算法对总雅可比矩阵进行在线估计,验证所提出的基于SR-UKF算法在线估计总图像雅可比矩阵方法的有效性。190仿真实验以二自由度机器人为对象,摄像机安装在机器人的末端,假设摄像机坐标系与机器人末端坐标系重合,通过控制机器人运动使其末端跟踪运动目标。机器人为两连杆机械臂,[-,]其杆长均为1m,两关节角的变化范围均为。摄像机成像模型采用理想的针孔模型,摄像机焦距为0.008m,图像在x和y轴方向的分辨率均为100000pixels/m,图像平面大小为1024x1024pixels,图像中心像素坐标为(512,512)pixel。195假设目标物体为点状物体,选取目标点在图像平面像素坐标的横坐标u和纵坐标v为目标的yy图像特征,设目标点期望图像特征为图像中心像素坐标(512,512)pixel,机器人末端初始位置为(1,-1,0)m,采样时间t为20ms。SR-UKF算法中的状态估计误差协方5PI10IS差矩阵的初始值取为06(n为n维单位阵),其平方根矩阵即为0,过程噪声协方Q05.IQ05.I差矩阵取为w6,图像观测噪声协方差矩阵取为v2。2003.1跟踪圆周运动目标跟踪圆周运动目标仿真实验示意图如图2所示,目标点的圆周运动方程(单位为m)为x105cos(.kt)y105sin(.kt)(29)z1式中,为角速度,k为迭代次数,t为采样时间。-7-

中国科技论文在线http://www.paper.edu.cn205图2跟踪圆周运动目标示意图仿真实验中,取角速度为2rad/s,分别使用KF、UKF和SR-UKF算法对总图像雅可比矩阵进行在线估计,实现对运动目标的跟踪。三种算法的仿真实验结果如图3、4、5所示。图3为图像平面跟踪轨迹图,图中圆点和方形点分别表示机器人末端初始位置和目标初始位置,点划线为目标运动轨迹,双划线、实线和虚线分别为基于KF、UKF和SR-UKF算210法的跟踪轨迹,与目标运动轨迹相比,基于KF和UKF算法的跟踪轨迹存在波动及偏离,而基于SR-UKF算法的跟踪轨迹与目标运动轨迹基本吻合,跟踪效果最好。图5和图6分别为三种算法的图像特征误差范数曲线和图像特征的u轴及v轴误差曲线,可以看出基于SR-UKF算法的误差曲线收敛最快,曲线波动最小,比KF和UKF算法具有更高的跟踪精度。图像平面跟踪轨迹-0.5-0.6目标点运动轨迹-0.7KF跟踪轨迹UKF跟踪轨迹-0.8SR-UKF跟踪轨迹目标点初始位置-0.9机器人末端初始位置-1y/m-1.1-1.2-1.3-1.4-1.50.50.60.70.80.911.11.21.31.41.5215x/m图3图像平面跟踪轨迹图像特征误差范数曲线450KF400UKFSR-UKF350300/pixel250200150图像特征误差范数100500020406080100120140160采样步数图4图像特征误差范数曲线-8-

中国科技论文在线http://www.paper.edu.cn图像特征误差曲线500/pixel-50KF轴误差UKFu-100SR-UKF-150020406080100120140160600KF400UKF/pixelSR-UKF200轴误差v0-200020406080100120140160采样步数220图5图像特征的u和v轴误差曲线3.2跟踪方形运动目标为了验证本文所提出的算法对跟踪存在突变运动目标的有效性,进行跟踪方形运动目标仿真实验,示意图如图6所示。目标运动轨迹是边长为0.8m、中心为(1,-1,1)m的正方形轨迹,目标点初始位置为(1.4,-1.4,1)m,按逆时针以速度v=1m/s进行运动。同样225分别用KF、UKF和SR-UKF对总图像雅可比矩阵进行在线估计,实现对运动目标点的跟踪,三种算法的仿真实验结果如图7、8、9所示。从实验结果同样可以看出,基于SR-UKF算法的跟踪效果优于KF和UKF算法,验证了本文所提出的无标定视觉伺服算法也能够有效的跟踪运动存在突变情况的目标。230图6跟踪方形运动目标示意图-9-

中国科技论文在线http://www.paper.edu.cn图像平面跟踪轨迹-0.5-0.6目标点运动轨迹-0.7KF跟踪轨迹UKF跟踪轨迹-0.8SR-UKF跟踪轨迹-0.9目标点初始位置机器人末端初始位置-1y/m-1.1-1.2-1.3-1.4-1.50.50.60.70.80.911.11.21.31.41.5x/m图7图像平面跟踪轨迹图像特征误差范数曲线500KF450UKFSR-UKF400350/pixel300250200图像特征误差范数150100500020406080100120140160采样步数图8图像特征误差范数曲线图像特征误差曲线400KF300UKFSR-UKF/pixel200100轴误差u0-100020406080100120140160400KF300UKFSR-UKF/pixel200100轴误差v0-100020406080100120140160采样步数235图9图像特征的u和v轴误差曲线下面对这三种算法的跟踪效果进行进一步的比较。在相同的条件下,对三种算法分别进行10次仿真,记录每次仿真的实验数据,并定义如下均方误差(Mean-SquareError,MSE)Nn11MSEfi,j(30)Nnij11240式中,f为图像特征误差,n为一次仿真的迭代次数,N为仿真总次数。-10-

中国科技论文在线http://www.paper.edu.cn对于跟踪圆周运动目标,分别取角速度为0.4、2、4rad/s;对于跟踪方形运动目标,分别取运动速度v为0.2、1、2m/s。仿真实验结果如表1所示,由表1数据可知,随着目标运动速度增大,跟踪均方误差(MSE)变大。基于KF算法的跟踪均方误差最大,UKF算法次之,本文所使用的SR-UKF算法的跟踪均方误差最小,跟踪精度最高。245表1跟踪均方误差(MSE/pixel)比较圆周运动(rad/s)方形运动(m/s)算法0.4240.212KF5.033521.286340.76955.112122.687241.2364UKF4.854018.620138.84794.963820.735339.2280SR-UKF4.586913.645832.60534.789214.964534.2843从上面仿真实验结果可知,基于KF算法的跟踪轨迹波动较大,跟踪精度比较差;基于UKF算法的跟踪效果相对KF算法有一定的改善;而本文所使用的SR-UKF算法的跟踪效果在UKF算法基础上得到进一步提升,其跟踪轨迹比较稳定,跟踪精度最高。2504结论本文针对无标定视觉伺服中图像雅可比矩阵的在线估计问题,提出了一种基于SR-UKF的图像雅可比矩阵在线估计方法。该方法将总图像雅可比矩阵的元素作为系统状态,再使用SR-UKF算法实现对总图像雅可比矩阵的在线估计,从而解决了在无标定环境下对图像雅可比矩阵精确辨识的问题,避免了复杂的系统标定过程。基于SR-UKF的估计方法用采样方法255逼近非线性系统,比传统KF算法有更高的估计精度;采用确定性采样策略,而非PF的随机采样,从而避免了PF的粒子退化问题;相比于UKF,SR-UKF直接以误差协方差矩阵的平方根矩阵进行递推计算,保证了误差协方差矩阵的非负定性,提高了算法的稳定性和计算效率。在Matlab实验平台上以二自由度机器人跟踪运动目标为视觉伺服任务,将新提出的方法与基于卡尔曼滤波和无迹卡尔曼滤波的估计方法进行实验比较。仿真实验结果表明,所260提出的图像雅可比矩阵在线估计方法具有更高的估计精度和更强的鲁棒性。下一步的工作是在实验室开展实物实验研究,实验验证本文所提出的图像雅可比矩阵在线估计方法跟踪运动目标的有效性。[参考文献](References)[1]HUTCHINSONS,HAGERGD,CORKEPI.Atutorialonvisualservocontrol[J].RoboticsandAutomation,265IEEETransactionson,1996,12(5):651-670.[2]CHAUMETTEF,HUTCHINSONS.Visualservocontrol.I.Basicapproaches[J].Robotics&AutomationMagazine,IEEE,2006,13(4):82-90.[3]WEISSLE,SANDERSONAC,NEUMANCP.Dynamicsensor-basedcontrolofrobotswithvisualfeedback[J].RoboticsandAutomation,IEEEJournalof,1987,3(5):404-417.270[4]MALISE.Visualservoinginvarianttochangesincamera-intrinsicparameters[J].RoboticsandAutomation,IEEETransactionson,2004,20(1):72-81.[5]HAOM,SUNZ.Auniversalstate-spaceapproachtouncalibratedmodel-freevisualservoing[J].Mechatronics,IEEE/ASMETransactionson,2012,17(5):833-846.[6]MUSIĆJ,BONKOVIĆM,CECIĆM.ComparisonofUncalibratedModel-freeVisualServoingMethodsfor275Small-amplitudeMovements:ASimulationStudy[J].Internationaljournalofadvancedroboticsystems,2014,1729:8806.[7]ZhongX,ZhongX,PengX.RobotsvisualservocontrolwithfeaturesconstraintemployingKalman-neural-networkfilteringscheme[J].Neurocomputing,2015,151:268-277.[8]QIANJ,SUJ.On-lineestimationofimageJacobianmatrixbasedonKalmanfilter[J].ControlandDecision,-11-

中国科技论文在线http://www.paper.edu.cn2802003,18(1):77-80.(钱江,苏剑波.图像雅可比矩阵的在线Kalman滤波估计[J].控制与决策,2003,18(1):77-80.)[9]LVX,HUANGX.FuzzyadaptiveKalmanfilteringbasedestimationofimageJacobianforuncalibratedvisualservoing[C]//IntelligentRobotsandSystems,2006IEEE/RSJInternationalConferenceon.IEEE,2006:2167-2172.[10]ZHAOQ,CHENY,ZHANGL.On-lineestimationofJacobianmatrixbasedonParticlefilter[J].285TransactionsofBeijingInstituteofTechnology,2008,28(5):401-404.(赵清杰,陈云蛟,张立群.基于粒子滤波的雅可比矩阵在线估计技术[J].北京理工大学学报,2008,28(5):401-404.)[11]ZHANGY.UnscentedKalmanfilterforon-lineestimationofJacobianmatrix[J].JournalofComputerApplications,2011,31(06):1699-1702.(张应博.基于无极卡尔曼滤波算法的雅可比矩阵估计[J].计算机应用,2011,31(06):1699-1702.)290[12]VANDERMERWER,WANEA.Thesquare-rootunscentedKalmanfilterforstateandparameter-estimation[C]//Acoustics,Speech,andSignalProcessing,2001.Proceedings.(ICASSP"01).2001IEEEInternationalConferenceon.IEEE,2001,6:3461-3464.[13]PIEPMEIERJA,LIPKINH.Uncalibratedeye-in-handvisualservoing[J].TheInternationalJournalofRoboticsResearch,2003,22(10-11):805-819.295[14]PIEPMEIERJA,MCMURRAYGV,LIPKINH.Uncalibrateddynamicvisualservoing[J].RoboticsandAutomation,IEEETransactionson,2004,20(1):143-147.[15]KIMGW.UncalibratedVisualServoingthroughtheEfficientEstimationoftheImageJacobianforLargeResidual[J].JournalofElectricalEngineering&Technology,2013,8(2):385-392.[16]CORKEP.AroboticstoolboxforMATLAB[J].Robotics&AutomationMagazine,IEEE,1996,3(1):24-32.300[17]CORKEPI.TheMachineVisionToolbox:aMATLABtoolboxforvisionandvision-basedcontrol[J].Robotics&AutomationMagazine,IEEE,2005,12(4):16-25.-12-'

您可能关注的文档

- 国内科学学的学术群体与研究热点分析.pdf

- 基于Fe3O4和Man-CQDs纳米探针双标记模式定量检测沙门氏菌.pdf

- 基于QAR数据的飞行环境及驾驶操作定量评价模型.pdf

- 基于SOI结构的光波导表面光滑化机理.pdf

- 基于Web的PM2.5监测预警系统的设计.pdf

- 基于WEB的三维树木监管系统设计与实现.pdf

- 基于两级插值的图像矩阵补全.pdf

- 基于动态体压分布的汽车座椅振动舒适度预测.pdf

- 基于卷积神经网络的路面病害检测技术.pdf

- 基于微波退火技术制备的高性能短沟道金属源漏Ge pMOSFET.pdf

- 基于德温特专利共现网络的石墨烯核心技术变迁趋势分析.pdf

- 基于正交试验分析熔融沉积成型精度因素.pdf

- 基于电流新息的改进配电网故障定位算法.pdf

- 基于稀疏约束的人体全身运动合成方法.pdf

- 基于网络结构和流量特征相似性的僵尸网络检测方法.pdf

- 基于虚拟化的windows驱动程序动态分析方法.pdf

- 基于视觉词和海明距离优化机制的相似图片检索系统的研究.pdf

- 基于雷达数据的高炉料层分布研究.pdf

相关文档

- 施工规范CECS140-2002给水排水工程埋地管芯缠丝预应力混凝土管和预应力钢筒混凝土管管道结构设计规程

- 施工规范CECS141-2002给水排水工程埋地钢管管道结构设计规程

- 施工规范CECS142-2002给水排水工程埋地铸铁管管道结构设计规程

- 施工规范CECS143-2002给水排水工程埋地预制混凝土圆形管管道结构设计规程

- 施工规范CECS145-2002给水排水工程埋地矩形管管道结构设计规程

- 施工规范CECS190-2005给水排水工程埋地玻璃纤维增强塑料夹砂管管道结构设计规程

- cecs 140:2002 给水排水工程埋地管芯缠丝预应力混凝土管和预应力钢筒混凝土管管道结构设计规程(含条文说明)

- cecs 141:2002 给水排水工程埋地钢管管道结构设计规程 条文说明

- cecs 140:2002 给水排水工程埋地管芯缠丝预应力混凝土管和预应力钢筒混凝土管管道结构设计规程 条文说明

- cecs 142:2002 给水排水工程埋地铸铁管管道结构设计规程 条文说明