- 466.37 KB

- 2022-04-22 13:44:13 发布

- 1、本文档共5页,可阅读全部内容。

- 2、本文档内容版权归属内容提供方,所产生的收益全部归内容提供方所有。如果您对本文有版权争议,可选择认领,认领后既往收益都归您。

- 3、本文档由用户上传,本站不保证质量和数量令人满意,可能有诸多瑕疵,付费之前,请仔细先通过免费阅读内容等途径辨别内容交易风险。如存在严重挂羊头卖狗肉之情形,可联系本站下载客服投诉处理。

- 文档侵权举报电话:19940600175。

'中国科技论文在线http://www.paper.edu.cn基于区域映射与全概率模型的多示例图像#检索方法*吴建国,李辉5(安徽大学计算机科学与技术学院安徽合肥230601)摘要:针对语义图像的检索问题,提出基于区域映射与全概率模型的多示例检索方法。该方法把图像看成多示例包,图像上的区域看成示例,首先对每一张图像进行SLIC超像素分割,通过寻找图像上的关键点,并在该图像上进行区域映射,把关键点所在的超像素区域取出,提取该区域的颜色、纹理特征,生成该图像的多示例包,然后利用视觉语义模型和全概率模10型获得包特征,最后使用支持向量机进行学习,获得查询模型,并对检索结果按相关性大小进行排序。所提方法不仅使用了关键点映射的思想充分利用了关键点所属区域的感兴趣信息,而且使用了全概率模型充分考虑到了示例在包中的重要程度,提高了检索准确率。在Corel数据集和SIVAL数据集上的对比实验表明,该方法具有良好的性能。关键词:区域映射;全概率模型;多示例学习;图像检索15中图分类号:TP391.4AMulti-instanceImageRetrievalMethodBasedonRegionMappingandTheTotalProbabilityModel20WUJianGuo,LIhui(SchoolofComputerScienceandTechnology,Anhuiuniversity,Hefei230601,Anhui,China)Abstract:Aimingatsolvingtheproblemofsemanticimageretrieval,amulti-instanceimageretrievalmethodbasedonregionmappingandthetotalprobabilitymodel(TPM)isproposedinthispaper.Itregardsanimageasabagandtheregionsintheimageasinstances.Firstly,eachimageissegmented25bythemethodofSimpleLinearIterativeClustering(SLIC).Secondly,thekeypointsarefoundoutfromtheimageandmapthepointstotheregions.Thirdly,thefeaturesofcolorandtextureareextractedfromthosesuper-pixelswhicharemappedbythekeypoints,andthebagisgeneratedbythefeaturespace.Fourthly,thefeaturesofthebagwillbeproducedbyusingthevisualsemanticmodel(VSM)andTPM.Finally,theSupportVectorMachineisusedtobuildthequerymodelandthequery30resultsaresortedaccordingtothecorrelation.TheproposedmethodmakesfulluseoftheinformationoftheregionwhichcontainsthekeypointsbyusingtheideaofregionmappingandalsofullytakestheimportanceoftheinstanceinthebagintoaccountbyusingTPMsothattheaccuracyoftheimageretrievalisimproved.ItisprovedthatourmethodhasbetteraccuracybycomparingwithothermethodsthroughtheexperimentsontheimagedatasetsoftheCorelandSIVALbenchmarks.35Keywords:regionmapping;totalprobabilitymodel;multi-instancelearning;imageretrieval0引言从急剧增长的图像库中选择自己感兴趣的图像成为人们迫切的需求,然而由于图像的语40义非常丰富,这使得基于内容的图像检索成为一个非常具有挑战性的难题。经典的基于内容[1-2]的图像检索(content-basedimageretrieval,CBIR)方法尽管采用了图像的颜色、纹理、形状等特征,但是检索的准确度被图像的多语义性所局限。基金项目:2013年高等学校博士学科点专项科研基金联合资助课题(20133401110009)作者简介:吴建国,教授,博士生导师.E-mail:wjg5408@163.com-1-

中国科技论文在线http://www.paper.edu.cn[3-17]45多示例学习(Multi-instancelearning,MIL)是一种机器学习框架,它认为训练集是由一组具有标记的包组成的,每个包中均含有一组示例,但是示例的标记具有不确定性,正包中至少有一个正示例,负包中的示例均是负示例,这一描述恰好与图像多语义性的特点相符合,因此利用多示例学习来解决语义图像检索的问题是可行的。自1997年ThomasG.[3]Dietterich提出多示例学习的概念以来,研究者们便将多示例学习应用于图像检索,如[4-5]50RouhollahRahman等人使用多示例学习方法设计了CBIR系统,ACCIO!,后来他们又提[7-8]出了基于多示例学习的半监督方法MISSL用于改善CBIR系统。Chen等提出了经典的DD-SVM与MILES多示例学习算法,通过构造示例空间获得多示例包特征,将多示例问题[9-11]转换为监督学习问题继而使用支持向量机求解。Yeong-YuhXu等提出神经网络与多示例学习相结合的MI-BDNN方法,并成功应用于图像检索问题。55MIL框架下的图像检索,存在两个问题:1.如何生成多示例包;2.如何提取多示例包的特征。针对第一个问题,论文采用关键点映射的方法,即使用SILC超像素分割方法分割图[12]像和HerbertBay等人提出的SURF(Speed-UpRobustFeatures)方法的定位关键点,对于包含SURF关键点的分割区域提取颜色、纹理特征,生成多示例包,充分利用了关键点所属区域的感兴趣信息。针对第二个问题,采用了基于全概率模型的多示例相关度计算方法,充60分考虑了示例在包中的重要程度。1相关介绍1.1SLIC超像素分割SLIC算法是一种简单线性迭代的聚类算法,该算法首先计算每一个像素点的CIELab颜色特征和二维空间位置特征,获得图像的特征空间;其次在图像中初始化k个种子点,将65它们作为初始化的聚类中心,为了保证种子点均匀的分布在图像的网格中,设置了网格间距S,取S=/Nk,N表示图像中像素的总个数;然后计算2S距离内像素和种子点的距离,更新每一个像素点的聚类标记。在论文实验中k取150,图像的SLIC分割效果如图1所示。图1SLIC超像素分割效果图70Fig.1GraphmodelofSLICsuperpixelsegmention1.2SURF关键点定位在SURF关键点的定位过程中,首先利用模拟二阶高斯拉布拉斯算子的盒状滤波器构造尺度空间上的图像堆,然后根据尺度空间内中间层图像上像素点的二阶Hession矩阵响应值作为评判SURF关键点的依据,最后使用泰勒公式拟合具体的SURF关键点的位置,SURF75关键点具有尺度不变性、灰度不变性以及旋转不变性。-2-

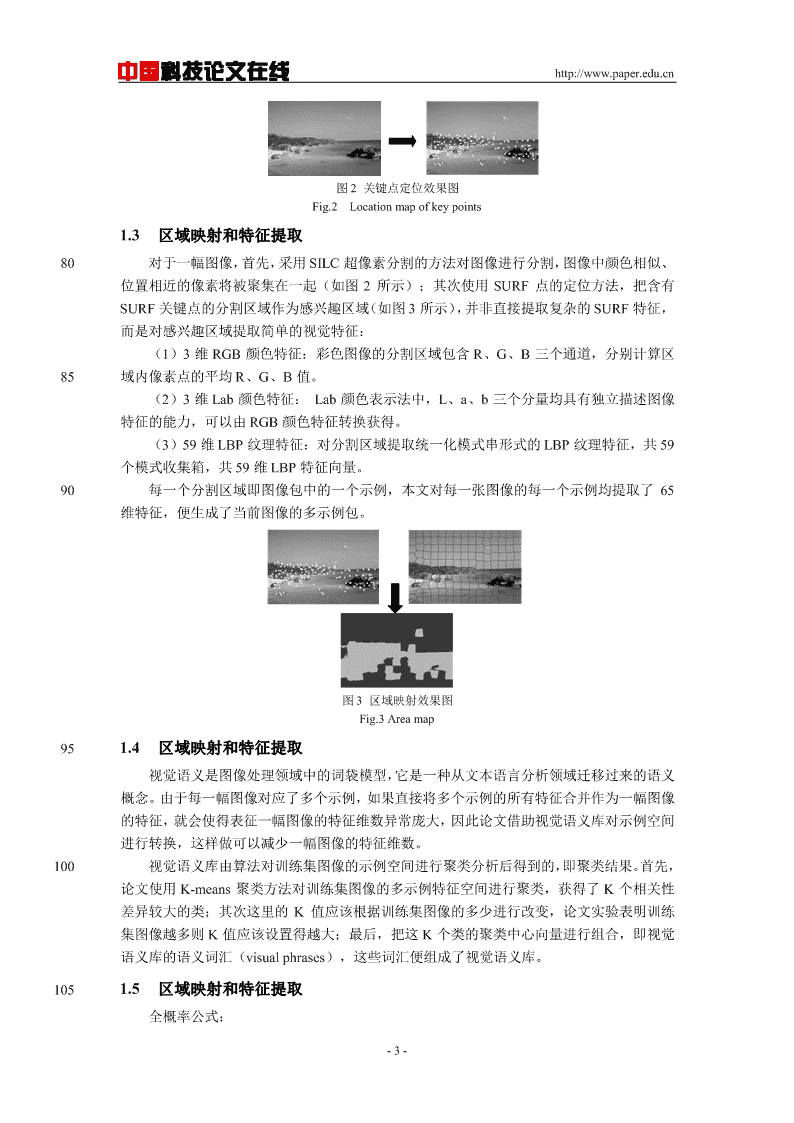

中国科技论文在线http://www.paper.edu.cn图2关键点定位效果图Fig.2Locationmapofkeypoints1.3区域映射和特征提取80对于一幅图像,首先,采用SILC超像素分割的方法对图像进行分割,图像中颜色相似、位置相近的像素将被聚集在一起(如图2所示);其次使用SURF点的定位方法,把含有SURF关键点的分割区域作为感兴趣区域(如图3所示),并非直接提取复杂的SURF特征,而是对感兴趣区域提取简单的视觉特征:(1)3维RGB颜色特征:彩色图像的分割区域包含R、G、B三个通道,分别计算区85域内像素点的平均R、G、B值。(2)3维Lab颜色特征:Lab颜色表示法中,L、a、b三个分量均具有独立描述图像特征的能力,可以由RGB颜色特征转换获得。(3)59维LBP纹理特征:对分割区域提取统一化模式串形式的LBP纹理特征,共59个模式收集箱,共59维LBP特征向量。90每一个分割区域即图像包中的一个示例,本文对每一张图像的每一个示例均提取了65维特征,便生成了当前图像的多示例包。图3区域映射效果图Fig.3Areamap951.4区域映射和特征提取视觉语义是图像处理领域中的词袋模型,它是一种从文本语言分析领域迁移过来的语义概念。由于每一幅图像对应了多个示例,如果直接将多个示例的所有特征合并作为一幅图像的特征,就会使得表征一幅图像的特征维数异常庞大,因此论文借助视觉语义库对示例空间进行转换,这样做可以减少一幅图像的特征维数。100视觉语义库由算法对训练集图像的示例空间进行聚类分析后得到的,即聚类结果。首先,论文使用K-means聚类方法对训练集图像的多示例特征空间进行聚类,获得了K个相关性差异较大的类;其次这里的K值应该根据训练集图像的多少进行改变,论文实验表明训练集图像越多则K值应该设置得越大;最后,把这K个类的聚类中心向量进行组合,即视觉语义库的语义词汇(visualphrases),这些词汇便组成了视觉语义库。1051.5区域映射和特征提取全概率公式:-3-

中国科技论文在线http://www.paper.edu.cnnPclassjPinsti*Pclassinstjii1(1)2dist(x,center)/ijPclassinstji=e(2)论文把一幅图像看成多示例包,一个包中包含多个示例。在公式(1)中insti指一幅多示110例图像包内的第i个示例,classj指第j个视觉语义类(1.4节的结果)。P(classj)定义为该幅多示例图像与类classj的相关程度,称之为多示例相关度概率,并记为事件classj。那么P(classj|insti)可以被看成是第i个示例相关于第j个视觉语义类的概率,它可以被定义为当前示例向量与类的中心向量的归一化距离,见公式(2),其中为尺度调整因子。而P(insti)的意义就是该幅图像包含示例insti的概率,记为事件insti,即该示例(分割区域)在图像上的重要程115度,这个重要程度可以是显著程度、区域面积的大小等,从数学的角度分析就是区域权值。在上述的叙述中,由于一幅图像包是由示例组成的,因此事件inst1,inst2,inst3......组成了一个完备的事件集合,本文使用全概率公式(1)计算包特征是合理的。1.6支持向量机由于本文提取了多示例包的包特征,因此可以直接使用支持向量机(SupportVector120Machine,简称SVM)建立分类模型。设训练集{(bagFeai,yi)|0threshold16510)setflag(j)=111)end12)end13)useStep6togetthemiSpaceofI14)useStep7togetthevisualCentersofmiSpace17015)forWjvisualCenters{K}16)setcenter=Wj17)forXimiSpace{Q}18)useequation(2)19)P(classj)=P(classj)+P(insti)*P(classj|insti)17520)end21)bagFea(j)=P(classj)22)end23)BagFeas{Ic}=bagFea;24)end-5-

中国科技论文在线http://www.paper.edu.cn1803实验结果与分析为了验证本文方法的有效性,论文采用了Intel(R)Core(TM)i5-4570的CPU,8GB的内存,windows864位操作系统的计算机开发环境,使用了matlabR2012a软件作为实验的仿真开发平台,分别在Corel数据集与SIVAL数据集上做了检索实验。3.1评价指标185为了便于与其它方法作比较,在Corel数据集上,实验使用查准率作为评价指标,它被定义为检索结果中相关图像的数目占检索结果总图像数目的百分比;在SIVAL数据集上,实验采用描述检索系统分类器性能的受试者工作特征曲线ReceiverOperatingCharacteristic(ROC)中的AreaUnderCurve(AUC)值作为评价指标,AUC值表示ROC曲线与坐标轴、直线x=1围成的面积大小。1903.2Corel数据集上的对比实验实验选取的Corel数据集是由Corel图像库中的前1000幅图像组成,总共10个类别,编号为1至10,每一个类别均包含一个主题,分别为:非洲、海滩、建筑、公交车、恐龙、象群、花朵、马群、大山以及食物,每类100幅,大小均为384*256或者256*384的彩色图[6]像,部分图像如图4所示。为了验证Map-TPM算法的有效性,论文将其与经典的SBN[7]195(singleblobwithneighbors)和Chen的RR(ReasoningwithRegions)两种方法做对比。图4Corel图像集的部分图像Fig.4ImagesofCoreldataset论文对每一类图像均做了10次实验,10次实验的训练集均是由系统随机选择,包括5200幅正包图像和5幅负包图像。使用SVM对由本文方法提取的包特征进行训练。对于每一类图像实验的平均检索结果,共统计了检索实验返回的前10、前20和前30幅相关图像的查准率,实验结果如表1、表2、表3所示。表1Map-TPM与SBN、RR方法的前10幅图像的查准率比较Tab.1Thecomparisonofthefirst10imagesoftheMap-TPMwiththeSBN,RRmethod类别Map-TPMSBNRR非洲(1)91.00%54.00%66.00%-6-

中国科技论文在线http://www.paper.edu.cn海滩(2)81.00%82.00%57.00%建筑(3)83.00%55.00%71.00%公交(4)98.00%69.00%93.00%恐龙(5)100.00%100.00%98.00%象群(6)75.00%80.00%73.00%花朵(7)98.00%99.00%93.00%马群(8)99.00%96.00%92.00%大山(9)76.00%68.00%52.00%食物(10)98.00%61.00%98.00%平均89.90%76.40%79.30%205表2Map-TPM与SBN、RR方法的前20幅图像的查准率比较Tab.2Thecomparisonofthefirst20imagesoftheMap-TPMwiththeSBN,RRmethod类别Map-TPMSBNRR非洲(1)83.00%32.50%57.50%海滩(2)65.50%64.50%58.00%建筑(3)75.00%35.50%65.50%公交(4)93.00%46.50%90.50%恐龙(5)99.00%100.00%98.50%象群(6)63.50%56.50%68.00%花朵(7)99.00%94.50%96.50%马群(8)98.00%87.00%86.50%大山(9)70.00%51.00%59.00%食物(10)94.00%41.00%96.00%平均84.00%60.90%77.60%210表3Map-TPM与SBN、RR方法的前30幅图像的查准率比较Tab.3Thecomparisonofthefirst30imagesoftheMap-TPMwiththeSBN,RRmethod-7-

中国科技论文在线http://www.paper.edu.cn类别Map-TPMSBNRR非洲(1)74.33%25.33%57.00%海滩(2)59.33%56.00%54.33%建筑(3)66.67%27.00%60.33%公交(4)87.00%41.67%87.33%恐龙(5)99.00%100.00%99.00%象群(6)55.00%46.33%61.33%花朵(7)98.00%93.33%97.67%马群(8)95.33%76.00%81.67%大山(9)66.00%42.67%55.00%食物(10)92.33%33.33%94.33%平均79.30%54.17%74.80%Map-TPM在前10、前20和前30幅相关图像检索的准确率分别达到了89.90%、84.00%、79.30%。从表5.1、5.2、5.3可以看出论文的方法对于类别(1)、(4)、(5)、(7)、215(8)和(10)具有较高的检索准确度。另外,由于(2)、(3)、(6)和(9)4类图像由于本身具有非常复杂的场景,因此检索的准确度相对较低,但是也具有良好的检索效果。相较之下Map-TPM在这10类图像上的检索结果明显优于SBN、RR方法。3.3Sival数据集上的对比实验为了进一步验证论文方法的有效性,论文选用了SIVAL图像集进行对比实验。SIVAL220图像集含有25个类,分别是AjaxOrange、Apple、Banana、BlueScrunge、CandleWithHolder、CardboardBox、CheckeredScarf、CokeCan、DataMiningBook、DirtyRunningShoe、DirtyWorkGloves、FabricSoftenerBox、FeltFlowerRug、GlazedWoodPot、GoldMedal、GreenTeaBox、JuliesPot、LargeSpoon、RapBook、SmileyFaceDoll、SpriteCan、StripedNoteBook、TranslucentBowl、WD40Can和WoodRollingPin,论文将25个类依次编号为1至25,每类22560幅图像,共计1500幅,SIVAL图像集的特点是:每个类中只含有1种较小的目标物体,该物体被放在10种场景中,而每一种场景是在6种不同的角度下拍摄的,部分图像如图5所示。-8-

中国科技论文在线http://www.paper.edu.cn图5SIVAL图像集的部分图像230Fig.5ImagesofSIVALdataset在每次实验中,从某个类中随机选择8幅图像,标记为正包;而从其他类中随机选择8幅图像,标记为负包,这16幅图像组成了训练集,而剩下的1484幅图像组成了测试集,重复上述过程,论文对每一类图像均做了30组独立随机实验,并计算每组实验的平均AUC值,以及每组数据95%的置信度值。为了与已有的检索方法进行比较,论文采用受试者曲[8][4][5]235线中的AUC值作为评价指标,将Map-TPM与MI-BDNN、ACCIO!、MISSL方法进行比较,实验结果如表4所示,表中数据单位为百分比。表4SIVAL图像集上置信度为95%的30组独立重复实验的平均AUC值Tab.4TheaverageAUCvalueof30setsofindependentrepeatexperimentswith95%confidenceontheSIVALimageset类别Map-TPM(ours)MI-BDNNACCIO!MISSL189.0±1.977.0±3.490.0±2.178.2±5.2258.7±2.455.5±3.863.4±3.451.1±4.4369.6±1.965.9±3.362.4±4.354.6±2.8484.8±1.956.7±5.369.5±3.476.8±5.2566.5±2.668.8±2.384.5±0.868.0±5.5669.7±2.469.4±1.967.9±2.269.6±2.5780.4±1.990.8±1.688.9±0.793.8±1.1880.4±2.083.3±7.381.5±3.593.3±0.9982.8±2.274.7±3.477.3±4.359.4±5.61072.3±2.383.7±1.978.2±1.686.9±1.91167.3±2.765.3±1.573.8±3.472.2±3.51281.8±2.785.4±5.686.6±3.097.7±0.31377.2±2.586.9±1.790.5±1.192.8±0.91472.3±2.858.7±3.772.7±2.351.5±3.31577.8±2.577.7±2.683.4±2.762.3±4.01683.7±2.587.3±3.080.4±3.586.9±2.51781.5±2.279.2±2.668.0±5.267.4±5.3-9-

中国科技论文在线http://www.paper.edu.cn1864.0±2.457.6±2.350.2±2.158.4±1.61969.4±2.062.8±1.761.3±2.858.3±2.62079.7±2.477.4±3.380.7±2.054.6±2.82177.3±2.671.9±2.581.2±1.567.3±4.62265.2±2.570.2±3.270.2±2.968.9±5.02392.1±1.077.5±2.363.2±5.266.3±5.72481.2±2.382.0±2.493.9±0.978.6±3.92563.0±2.166.7±1.751.6±2.656.4±2.2平均75.569.674.674.8240从表4可以看出,Map-TPM在类别Banana、BlueScrunge、CardboardBox、DataMiningBook、JuliesPot、LargeSpoon、RapBook、SmileyFaceDoll、TranslucentBowl上的AUC值均高于MI-BDNN、ACCIO!、MISSL三种方法,尤其在TranslucentBowl类上,Map-TPM的AUC达到了92.1%,即Map-TPM对该类别的图像具有较高的区分能力。245Map-TPM在类别Apple上的AUC值仅为58.7%,这是由于该类图像的背景对目标造成了很大的影响,致使Map-TPM选择了大量背景部分的关键点,导致实验结果误差较大。从实验的整体上看,Map-TPM的AUC平均值为75.5%,高于其他三种方法。4结语在多示例图像检索过程中,图像本身所具备的感兴趣区域和示例在包中的重要程度不容250忽视,论文提出的基于区域映射和全概率模型的多示例图像检索方法,有效的解决了多示例包的生成和包特征的提取这两个问题,在Corel以及SIVAL数据集上的实验表明本文方法具有良好的性能。在今后的工作中,可以充分利用图像的背景信息,过滤错误的关键点信息,加强检索实验的负包选择能力,从而获得更好的检索效果。[参考文献](References)255[1]VermaA,SharmaD.Contentbasedimageretrievalusingcolor,textureandshapefeatures[J].InternationalJournalofAdvancedResearchinComputerScienceandSoftwareEngineering,2014,4(5)..[2]KokareM,ChatterjiBN,BiswasPK.Asurveyoncurrentcontentbasedimageretrievalmethods[J].IETEJournalofResearch,2002,48(3-4):261-271.[3]DietterichTG,LathropRH,Lozano-PérezT.Solvingthemultipleinstanceproblemwithaxis-parallel260rectangles[J].Artificialintelligence,1997,89(1):31-71.[4]RahmaniR,GoldmanSA,ZhangH,etal.Localizedcontentbasedimageretrieval[C]//Proceedingsofthe7thACMSIGMMinternationalworkshoponMultimediainformationretrieval.ACM,2005:227-236.[5]RahmaniR,GoldmanSA.MISSL:Multiple-instancesemi-supervisedlearning[C]//Proceedingsofthe23rdinternationalconferenceonMachinelearning.ACM,2006:705-712.265[6]MaronO,RatanAL.Multiple-InstanceLearningforNaturalSceneClassification[C]//ICML.1998,98:341-349.[7]ChenY,LiJ,WangJZ.CategorizationbyLearningandReasoningwithRegions[J].MachineLearningandStatisticalModelingApproachestoImageRetrieval,2004:99-121.[8]ChenY,BiJ,WangJZ.MILES:Multiple-instancelearningviaembeddedinstanceselection[J].IEEE270TransactionsonPatternAnalysisandMachineIntelligence,2006,28(12):1931-1947.[9]XuYY.Multiple-instancelearningbaseddecisionneuralnetworksforimageretrievalandclassification[J].Neurocomputing,2016,171:826-836.[10]XuYY,ShihCH.ContentbasedImageretrievalusingmultipleinstancedecisionbasedneuralnetworks[C]//ComputationalIntelligenceandCybernetics(CyberneticsCom),2012IEEEInternationalConference275on.IEEE,2012:175-179.-10-

中国科技论文在线http://www.paper.edu.cn[11]XuYY,ShihCH.Imageclassificationviamultiple-instancedecision-basedneuralnetworks[C]//ImageandGraphics(ICIG),2013SeventhInternationalConferenceon.IEEE,2013:394-399.[12]BayH,EssA,TuytelaarsT,etal.Speeded-uprobustfeatures(SURF)[J].Computervisionandimageunderstanding,2008,110(3):346-359.280[13]LinTC,YangMC,TsaiCY,etal.Query-adaptivemultipleinstancelearningforvideoinstanceretrieval[J].IEEETransactionsonImageProcessing,2015,24(4):1330-1340.[14]WuJ,YuY,HuangC,etal.Deepmultipleinstancelearningforimageclassificationandauto-annotation[C]//ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.2015:3460-3469.285[15]HongR,WangM,GaoY,etal.Imageannotationbymultiple-instancelearningwithdiscriminativefeaturemappingandselection[J].IEEEtransactionsoncybernetics,2014,44(5):669-680.[16]LiY,TaxDMJ,DuinRPW,etal.Multiple-instancelearningasaclassifiercombiningproblem[J].PatternRecognition,2013,46(3):865-874.[17]YiY,LinM.Humanactionrecognitionwithgraph-basedmultiple-instancelearning[J].PatternRecognition,2902016,53:148-162.-11-'

您可能关注的文档

- 吸热表面热辐射特性对太阳能腔式吸热器热效率的影响.pdf

- 四种发光甲虫的转录组测序和系统发育分析.pdf

- 四轮轮毂电机驱动电动汽车高效制动能量回收策略研究.pdf

- 固体氧化物燃料电池与微型燃气轮机发电系统半实物仿真研究.pdf

- 土下地膜覆盖对春玉米产量及水分利用效果的影响.pdf

- 基于ANSYS Workbench的4000Nm全液压坑道钻机回转平台优化设计.pdf

- 基于ECR低能电子照射的超精密金属抛光技术研究.pdf

- 基于SIFT的图像复制粘贴篡改检测.pdf

- 基于分层技术的快速最大方差展开算法及其在过程监测中的应用.pdf

- 基于卫星测高回波波形的南极海域重力异常研究.pdf

- 基于异丙醇锆阴极修饰层的高效聚合物太阳能电池.pdf

- 基于机器学习的信号测向方法.pdf

- 基于格兰杰因果关系磁刺激穴位对亚健康失眠的脑功能网络分析.pdf

- 基于正弦波波形的电网电压监测.pdf

- 基于毛细管结构的热式风速传感器设计.pdf

- 基于活性的格尔德霉素探针的设计及其抗肿瘤靶点的研究.pdf

- 基于生态原理的亚热带可持续农林复合经营评价.pdf

- 基于移动设备多传感器融合的室内定位系统.pdf

相关文档

- 施工规范CECS140-2002给水排水工程埋地管芯缠丝预应力混凝土管和预应力钢筒混凝土管管道结构设计规程

- 施工规范CECS141-2002给水排水工程埋地钢管管道结构设计规程

- 施工规范CECS142-2002给水排水工程埋地铸铁管管道结构设计规程

- 施工规范CECS143-2002给水排水工程埋地预制混凝土圆形管管道结构设计规程

- 施工规范CECS145-2002给水排水工程埋地矩形管管道结构设计规程

- 施工规范CECS190-2005给水排水工程埋地玻璃纤维增强塑料夹砂管管道结构设计规程

- cecs 140:2002 给水排水工程埋地管芯缠丝预应力混凝土管和预应力钢筒混凝土管管道结构设计规程(含条文说明)

- cecs 141:2002 给水排水工程埋地钢管管道结构设计规程 条文说明

- cecs 140:2002 给水排水工程埋地管芯缠丝预应力混凝土管和预应力钢筒混凝土管管道结构设计规程 条文说明

- cecs 142:2002 给水排水工程埋地铸铁管管道结构设计规程 条文说明